GPU H100 đã thiết lập kỷ lục mới trên tám bài kiểm tra trong các bài kiểm tra đào tạo MLPerf mới nhất, đặc biệt là trong bài kiểm tra mới cho Generative AI. Hiệu suất xuất sắc này được đạt được cả trên mỗi bộ tăng tốc và trên các máy chủ lớn.

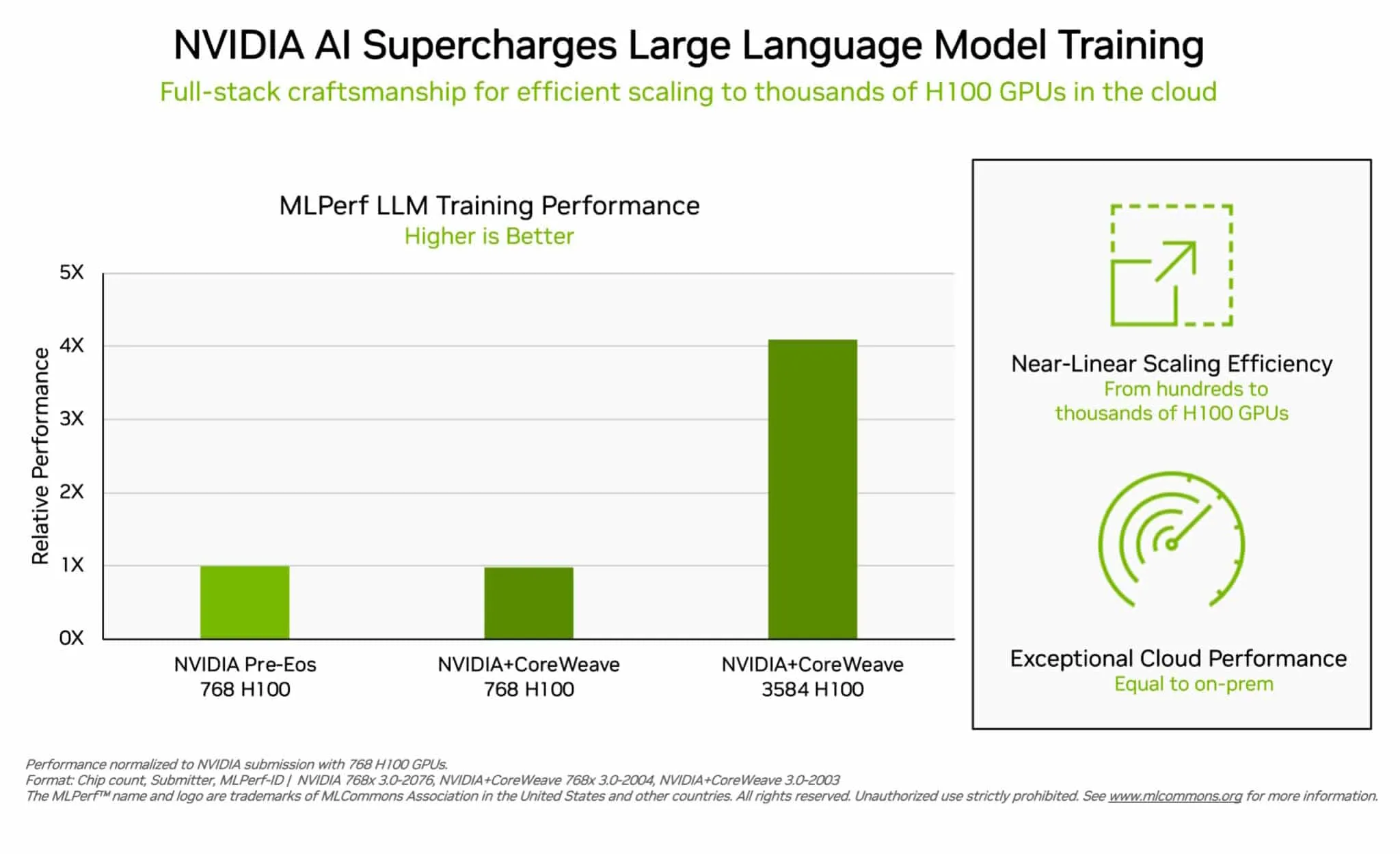

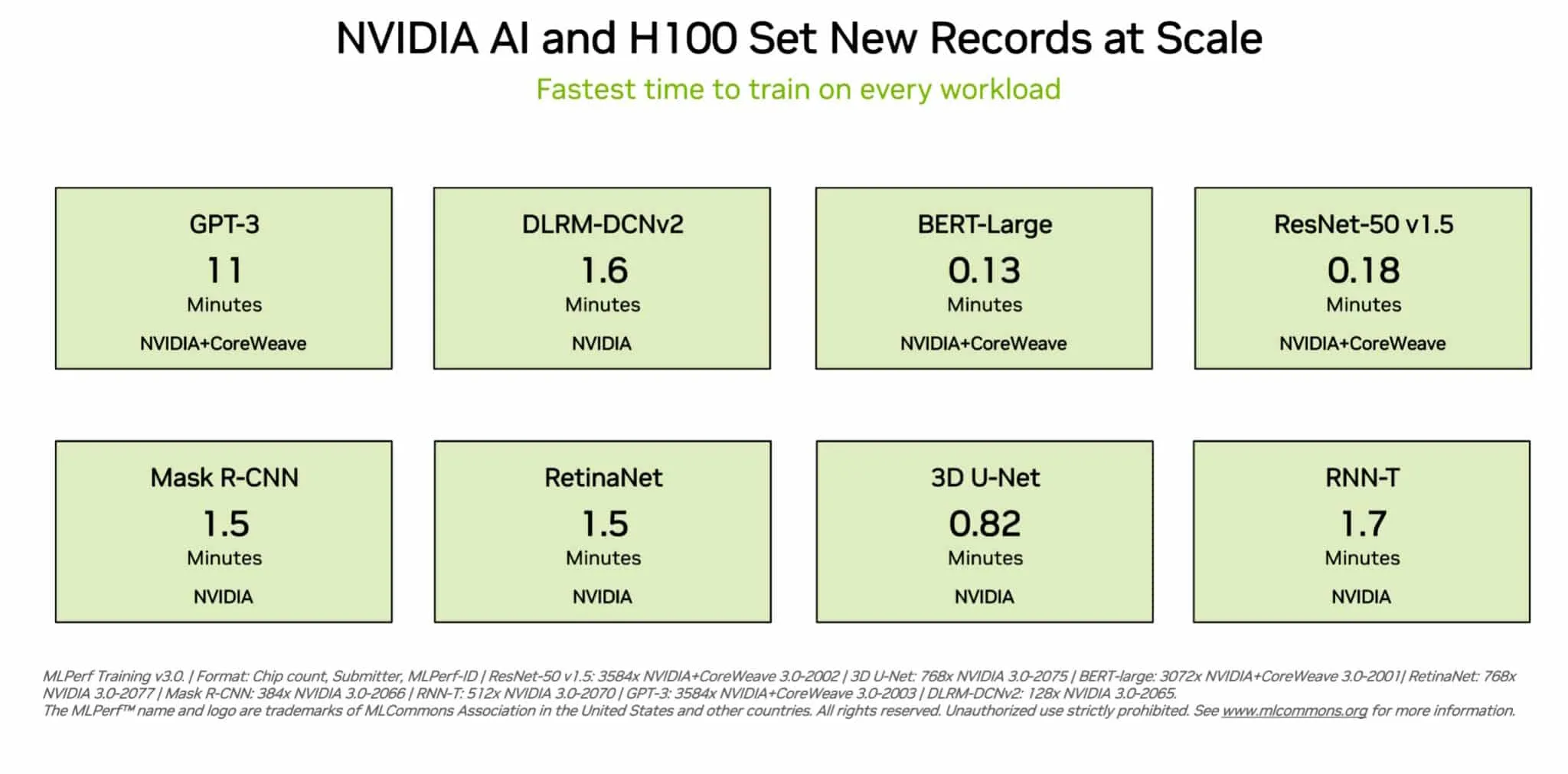

Ví dụ, trên một cụm GPU H100 có sẵn trên thị trường gồm 3.584 GPU, do công ty khởi nghiệp Inflection AI phát triển chung với CoreWeave, một nhà cung cấp dịch vụ đám mây chuyên về các tải công việc được tăng tốc bằng GPU, hệ thống đã hoàn thành bài kiểm tra đào tạo dựa trên mô hình lớn GPT-3 trong chưa đến mười một phút.

Inflection AI đã sử dụng hiệu suất đó để xây dựng LLM tiên tiến đằng sau trí tuệ nhân tạo cá nhân đầu tiên của họ, gọi là Pi, viết tắt của personal intelligence (trí tuệ cá nhân). Công ty sẽ hoạt động như một studio trí tuệ nhân tạo, tạo ra các trí tuệ nhân tạo cá nhân mà người dùng có thể tương tác một cách đơn giản và tự nhiên.

Inflection AI, được thành lập vào đầu năm 2022 bởi Mustafa và Karén Simonyan từ DeepMind và Reid Hoffman, nhằm hợp tác với CoreWeave để xây dựng một trong những cụm máy tính lớn nhất trên thế giới sử dụng GPU NVIDIA.

Các trải nghiệm của người dùng này phản ánh hiệu suất được thể hiện trong các bài kiểm tra MLPerf được thông báo ngày hôm nay.

- NVIDIA giành chiến thắng trong tám bài kiểm tra của MLPerf Training v3.0.

- GPU H100 cung cấp hiệu suất cao nhất trên mọi bài kiểm tra, bao gồm các mô hình ngôn ngữ lớn, hệ thống đề xuất, thị giác máy tính, hình ảnh y tế và nhận dạng giọng nói. Họ là duy nhất chạy tất cả tám bài kiểm tra, chứng tỏ tính linh hoạt của nền tảng AI của NVIDIA.

- Hiệu suất đạt được trong quá trình đào tạo thông thường là một công việc được thực hiện trên nhiều GPU làm việc cùng nhau. Trên mọi bài kiểm tra MLPerf, GPU H100 thiết lập kỷ lục hiệu suất ở quy mô lớn cho đào tạo AI.

- CoreWeave đạt được hiệu suất tương tự từ đám mây như NVIDIA đạt được từ một siêu máy tính AI chạy trong trung tâm dữ liệu cục bộ. Điều này chứng tỏ tính gắn kết thấp của mạng lưới InfiniBand Quantum-2 của NVIDIA mà CoreWeave sử dụng.

Trong vòng này, MLPerf cũng đã cập nhật bài kiểm tra cho các hệ thống đề xuất.

Bài kiểm tra mới sử dụng một bộ dữ liệu lớn hơn và một mô hình AI hiện đại hơn để phản ánh tốt hơn các thách thức mà các nhà cung cấp dịch vụ đám mây đối mặt. NVIDIA là công ty duy nhất đệ trình kết quả trên bài kiểm tra nâng cao này.

Với sự tham gia của gần mười hai công ty trên nền tảng NVIDIA trong vòng này, người dùng biết rằng họ có thể đạt được hiệu suất tuyệt vời với NVIDIA AI cả trong đám mây và trên các máy chủ chạy trong trung tâm dữ liệu riêng của mình.

Kết quả MLPerf được công bố hôm nay có sẵn trên các nền tảng H100, L4 và NVIDIA Jetson cho các bài kiểm tra đào tạo, suy luận và HPC. Chúng tôi sẽ tiếp tục đệ trình kết quả trên các hệ thống NVIDIA Grace Hopper trong các vòng MLPerf trong tương lai.

Tầm quan trọng của hiệu suất năng lượng

Khi yêu cầu hiệu suất của AI tăng lên, việc mở rộng hiệu suất đạt được là cực kỳ quan trọng. Đó là những gì tính toán tăng tốc làm.

Trung tâm dữ liệu được tăng tốc với GPU NVIDIA sử dụng ít nút máy chủ hơn, vì vậy chúng sử dụng ít không gian rack và năng lượng hơn. Ngoài ra, mạng lưới tăng tốc cải thiện hiệu suất và hiệu quả, và các tối ưu hóa phần mềm liên tục mang lại sự gia tăng hiệu suất trên cùng phần cứng.

Hiệu suất tiết kiệm năng lượng là tốt cho môi trường và cả doanh nghiệp. Hiệu suất tăng có thể giúp tăng tốc thời gian đưa sản phẩm ra thị trường và cho phép tổ chức xây dựng ứng dụng tiên tiến hơn.

Hiệu suất phù hợp với mọi tải công việc

Các đối tác hệ sinh thái của NVIDIA tham gia vào MLPerf vì họ biết rằng đó là một công cụ quan trọng cho khách hàng đánh giá các nền tảng và nhà cung cấp AI.

Các bài kiểm tra đánh giá những công việc mà người dùng quan tâm – thị giác máy tính, dịch và học tăng cường, bên cạnh AI sáng tạo và hệ thống đề xuất.

Người dùng có thể tin tưởng vào kết quả MLPerf để đưa ra quyết định mua hàng thông minh, vì các bài kiểm tra này minh bạch và khách quan. Các bài kiểm tra được hỗ trợ bởi một nhóm rộng lớn bao gồm Arm, Baidu, Facebook AI, Google, Harvard, Intel, Microsoft, Stanford và Đại học Toronto.

Kết quả MLPerf hiện có sẵn ngay hôm nay trên các nền tảng H100, L4 và NVIDIA Jetson cho các bài kiểm tra đào tạo, suy luận và HPC. Chúng tôi sẽ tiếp tục đệ trình kết quả trên các hệ thống NVIDIA Grace Hopper trong các vòng MLPerf trong tương lai.