Vào đầu năm nay, Sở Giáo dục Nam Úc đã quyết định đưa trí tuệ nhân tạo (AI) vào chương trình học. Tuy nhiên, trước khi triển khai, một câu hỏi lớn được đặt ra xoay quanh việc sử dụng AI một cách có trách nhiệm.

Ông Simon Chapman, Giám đốc Kiến trúc Kỹ thuật số của Sở Giáo dục Nam Úc, chia sẻ mối quan tâm chính của họ là làm sao để bảo vệ học sinh khỏi những nội dung có hại hoặc không phù hợp, có thể xuất hiện trong kết quả tìm kiếm quy mô lớn và chưa được lọc trên Internet. Ông cho biết: “Những gì mà phiên bản đại trà của AI tạo sinh có thể cung cấp vẫn còn rất hạn chế đối với ngành giáo dục. Không có quy định hay giới hạn nào trong việc sử dụng của học sinh. Hiện nay, chúng tôi cũng đang chuẩn bị hoàn tất quá trình thử nghiệm EdChat, một chatbot tích hợp AI. Gần 1,500 học sinh và 150 giáo viên từ 8 trường trung học đã tham gia thử nghiệm các tính năng của bot để tìm thông tin học tập.”

Ông Chapman cho biết, hiện nay Sở Giáo dục Nam Úc vẫn đang đánh giá kết quả của thử nghiệm EdChat. Tuy nhiên, hệ thống Azure AI Content Safety đến từ Microsoft, một nền tảng bảo vệ tích hợp AI, giúp các tổ chức xây dựng môi trường trực tuyến an toàn hơn, được sử dụng trong chatbot đã nhận được đánh giá cao.

Ông Chapman cho biết: tính năng an toàn tích hợp của EdChat đã ngăn chặn các tìm kiếm không phù hợp và loại bỏ các phản hồi có hại, giúp giáo viên tập trung tận dụng các lợi ích của công nghệ, thay vì phải giám sát nội dung. “Chúng tôi sẽ không thể triển khai với tốc độ như hiện nay nếu không có dịch vụ an toàn nội dung từ những ngày đầu. Đó là công cụ thiết yếu,” ông chia sẻ.

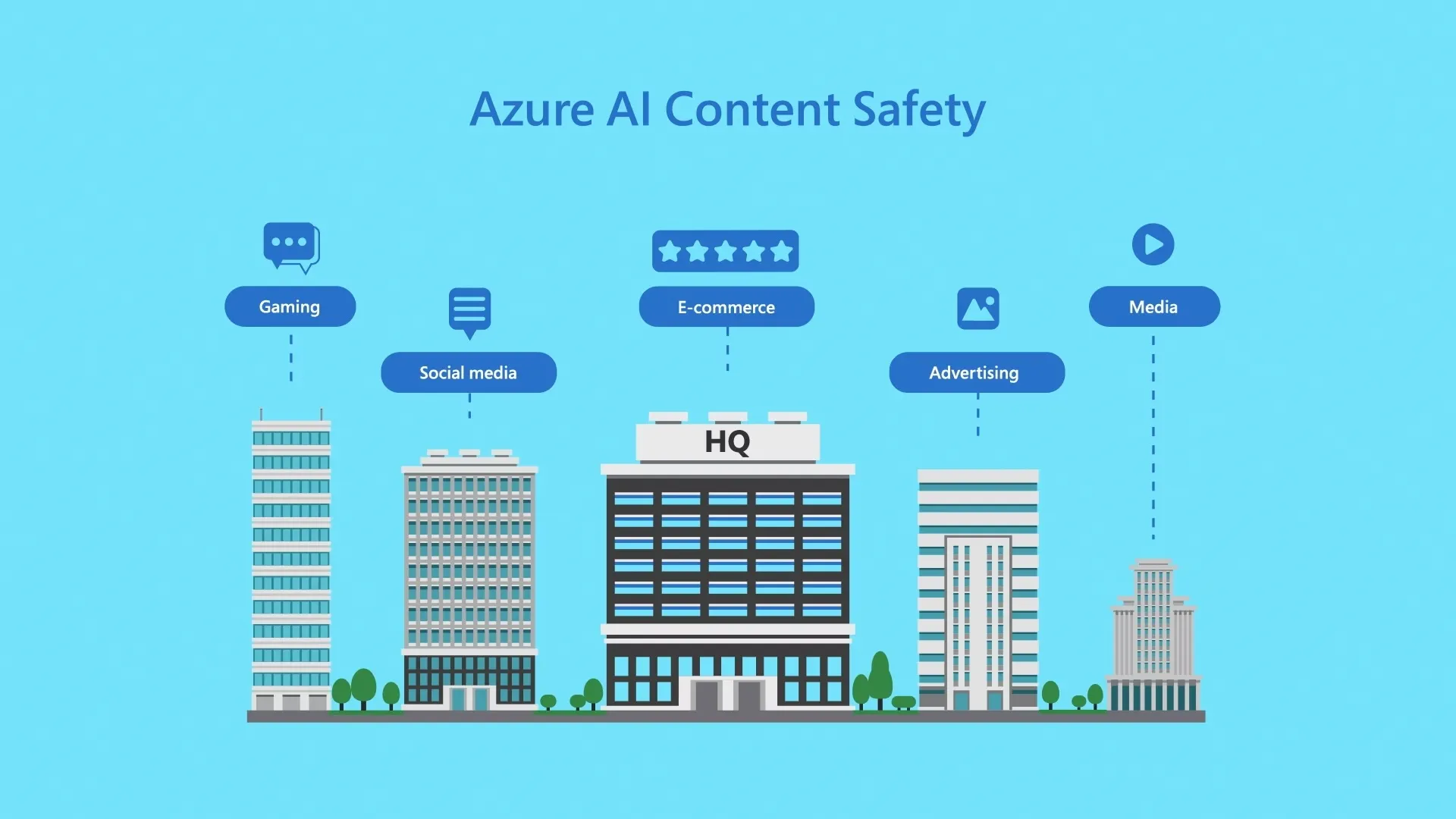

Hôm nay, Microsoft đã chính thức cho ra mắt tính năng Azure AI Content Safety trên nền tảng Azure AI. Nền tảng sử dụng các mô hình ngôn ngữ và hình ảnh nâng cao để phát hiện nội dung có tính chất thù địch, bạo lực, tình dục và tự làm hại bản thân. Khi các mô hình phát hiện nội dung có tiềm năng gây hại, chúng sẽ đánh dấu nội dung đó bằng điểm ước tính mức độ nghiêm trọng. Điều này cho phép các doanh nghiệp và tổ chức điều chỉnh dịch vụ của họ để ngăn chặn hoặc gắn cờ nội dung dựa trên chính sách riêng.

Theo thông tin từ Microsoft, mặc dù ban đầu được giới thiệu như một phần của Dịch vụ Azure OpenAI, Azure AI Content Safety hiện là một hệ thống độc lập. Điều đó có nghĩa là khách hàng có thể sử dụng công cụ này cho nội dung được tạo ra bởi AI từ các mô hình nguồn mở và mô hình của các công ty khác, cũng như cho nội dung được tạo ra bởi người dùng, như một phần trong hệ thống nội dung của họ.

Ông Eric Boyd, Phó Chủ tịch Phụ trách AI Platform của Microsoft, cho biết khi AI tạo sinh trở thành một công cụ phổ biến, Microsoft đặt mục tiêu trang bị cho các doanh nghiệp những công cụ cần thiết để triển khai một cách an toàn hơn.

Ông Boyd cũng chia sẻ thêm rằng: “Hiện tại, chúng ta đang ở một thời điểm khá thú vị, khi các công ty nhận thấy rõ sức mạnh đáng kinh ngạc của AI tạo sinh. Chúng tôi phát hành Azure AI Content Safety dưới dạng một sản phẩm độc lập để có thể phục vụ nhiều đối tượng khách hàng với nhiều nhu cầu kinh doanh đa dạng hơn.”

Đây chỉ là một ví dụ về cách Microsoft áp dụng các nguyên tắc xây dựng AI một cách có trách nhiệm vào thực tế. Công ty hiện có gần 350 nhân viên làm việc trong mảng này. Trong những năm qua, Microsoft đã ủng hộ việc quản lý AI có trách nhiệm và hỗ trợ Nhà Trắng Hoa Kỳ trong các cam kết tự nguyện về AI, thúc đẩy các giới hạn trong nghiên cứu AI có trách nhiệm để thu thập thông tin cho quá trình phát triển sản phẩm; ban hành Tiêu chuẩn AI có trách nhiệm để thiết kế, xây dựng và kiểm tra hệ thống AI; và đưa các công cụ như Bảng điều khiển AI có trách nhiệm của Azure Machine Learning đến tay khách hàng.

Bà Sarah Bird, Giám đốc Sản phẩm của Nhóm Đối tác tại Microsoft, chia sẻ rằng: “Đây không phải là một ý tưởng bổ sung mà là một phần cơ bản và không thể thiếu trong chiến lược đổi mới AI của chúng tôi từ những ngày đầu. Chúng tôi đang mang đến những công cụ tốt nhất để tìm ra cách giải quyết những thách thức về AI có trách nhiệm này. Và Azure AI Content Safety là một thành phần nền tảng, cho phép chúng tôi cung cấp các ứng dụng AI tạo sinh cho nhiều khách hàng hơn.”

Tùy chỉnh cho các mục đích sử dụng khác nhau

Trong nội bộ, Microsoft đã sử dụng Azure AI Content Safety để bảo vệ người dùng các sản phẩm tích hợp AI của Microsoft. Theo bà Sarah Bird, công nghệ này rất quan trọng để phát triển tính năng trò chuyện trong các sản phẩm như Bing, GitHub Copilot, Microsoft 365 Copilot và Azure Machine Learning. Trong một thế giới đầy ắp thông tin, các vấn đề liên quan đến AI có trách nhiệm đang diễn ra ở khắp các doanh nghiệp và ngành công nghiệp. Bởi vậy, khả năng tùy chỉnh các chính sách để phù hợp với môi trường và trường hợp sử dụng cụ thể của từng khách hàng chính là lợi thế của Azure AI Content Safety. Ví dụ, một nền tảng tập trung vào trò chơi có thể đặt ra các tiêu chuẩn khác nhau cho các khía cạnh như ngôn ngữ bạo lực so với nền tảng giáo dục được sử dụng trong lớp học.

Với công cụ kiểm duyệt hình ảnh của Azure AI Content Safety, Microsoft cho phép khách hàng có thể dễ dàng kiểm duyệt hình ảnh để đảm bảo rằng chúng đáp ứng các tiêu chuẩn nội dung họ đề ra.

Ví dụ, công ty năng lượng Shell đã phát triển một nền tảng AI tạo sinh có tên Shell E. Nền tảng này cho phép các nhóm tạo và triển khai các ứng dụng dựa trên mã nguồn mở và các mô hình ngôn ngữ lớn khác, cho phép nhân viên đặt câu hỏi và truy xuất thông tin để hỗ trợ quá trình làm việc của họ.

Theo ông Siva Chamarti, giám đốc kỹ thuật cấp cao của Hệ thống AI tại Shell: Shell E ra đời để giúp các nhân viên tiếp cận và sử dụng kiến thức của công ty một cách hiệu quả hơn. Nó có thể được ứng dụng trong tất cả các hoạt động của Shell, từ việc soạn thảo, tóm tắt và dịch nội dung đến việc tạo và kiểm thử mã, và quản lý kiến thức trên tất cả các lĩnh vực kỹ thuật. Các bộ phận cũng đang khám phá các trường hợp sử dụng phức tạp hơn như việc tạo các phân tử.

Cũng theo ông Chamarti, Azure AI Content Safety đóng vai trò then chốt trong việc quản lý nền tảng Shell E. Nó không chỉ hỗ trợ việc tạo văn bản và hình ảnh mà còn hạn chế các phản hồi không phù hợp hoặc có hại. Công cụ này kiểm tra từng thông tin đầu vào và đầu ra để đảm bảo tuân theo các chính sách trước khi nội dung đến tay người dùng.

Ôn Chamarti cho biết: “Chúng tôi rất mong đợi những tiềm năng của AI tạo sinh. Tuy chúng tôi mới đang ở giai đoạn đầu, nhưng các nhân viên đã và đang không ngừng sáng tạo và số lượng các tổ chức, đơn vị sử dụng đang ngày một gia tăng.”

Xây dựng lòng tin trong thời đại AI

Khi AI tạo sinh ngày càng phát triển, các rủi ro tiềm ẩn đối với không gian trực tuyến cũng sẽ gia tăng.

Theo bà Bird, để đối phó với những rủi ro đó, Microsoft sẽ liên tục cải tiến công nghệ thông qua kết hợp nghiên cứu và phản hồi từ khách hàng. Ví dụ, việc phát triển các mô hình đa phương thức vẫn được tiến hành liên tục để nâng cao khả năng phát hiện những nội dung phản cảm có sự kết hợp giữa hình ảnh và văn bản, chẳng hạn như meme. Những tổ hợp hình ảnh và văn bản này thường bị bỏ sót khi được kiểm duyệt bằng tính năng rà soát hình ảnh hoặc văn bản riêng lẻ.

Bên cạnh đó, ông Boyd cũng chia sẻ thêm rằng Microsoft đã có kinh nghiệm kiểm duyệt nội dung trong nhiều thập kỷ, sở hữu nhiều công cụ giúp bảo vệ người dùng trên nhiều nền tảng, từ diễn đàn Xbox cho đến công cụ tìm kiếm Bing. Azure AI Content Safety được phát triển dựa trên những kinh nghiệm này và Azure Content Moderator, một dịch vụ cho phép khách hàng khai thác khả năng phát hiện nội dung, kết hợp cùng khả năng của các mô hình ngôn ngữ và hình ảnh mới.

Bằng một cách tiếp cận toàn diện, Microsoft hy vọng có thể mở rộng việc ứng dụng AI một cách rộng rãi với sự tin tưởng của người tiêu dùng.

Theo ông Boyd: “Niềm tin đã trở thành nền tảng của thương hiệu Microsoft và Azure ngay từ những ngày đầu. Khi thế giới bước vào kỷ nguyên AI, chúng tôi sẽ tiếp tục mở rộng khả năng bảo vệ khách hàng của mình.”