Tại sự kiện COMPUTEX 2022, gã khổng lồ GPU NVIDIA không chỉ có những tin tức tuyệt vời liên quan đến những người tiêu dùng cơ bản mà họ còn chuẩn bị một số bản cập nhật và lộ trình cho thị trường ngành để giúp các đối tác và khách hàng chuyển đổi sang thế hệ hiệu suất cao sắp tới tin học. Hãy xem đó là những gì.

Sự ra mắt hoành tráng của Grace và Hopper tại Đài Loan

Tin tức lớn đầu tiên liên quan đến việc một số nhà sản xuất máy tính có trụ sở tại Đài Loan đang tiến gần đến việc ra mắt các hệ thống đầu tiên được cung cấp bởi NVIDIA Grace CPU Superchip và Grace Hopper Superchip nhắm mục tiêu đến các cặp song sinh kỹ thuật số hiệu suất cao, đồ họa đám mây, trò chơi trên đám mây và điện toán nói chung.

Với thời gian khả dụng dự kiến là Quý 1/2023, sẽ có hàng tá lựa chọn được cung cấp bởi ASUS, Foxconn Industrial Internet, GIGABYTE, QCT, Supermicro và Wiwynn, nơi khách hàng có thể chọn thứ phù hợp nhất có thể được tích hợp liền mạch vào hiện có máy chủ nền tảng x86/Arm.

Theo một số thông tin tóm tắt, Grace CPU Superchip có thiết kế chip CPU kép, được kết nối chặt chẽ thông qua kết nối NVLink-C2C chứa tối đa 144 lõi Arm V9 hiệu suất cao với phần mở rộng vectơ có thể mở rộng cùng hệ-thống-con có bộ nhớ 1TBps khổng lồ. Những kết quả cho phép cấu hình như vậy vốn chưa từng thấy trước đây như băng thông bộ nhớ gấp đôi và hiệu quả năng lượng sẽ phá vỡ các biểu đồ hiệu suất cùng một lúc.

Mặt khác, Grace Hopper Superchip sẽ đóng gói GPU NVIDIA Hopper với một CPU Grace duy nhất được kết nối với bằng NVLink-C2C, do đó có tên là “Grace” “Hopper”. Đối với kết hợp cụ thể này, việc xử lý HPC và các ứng dụng liên quan đến AI ở quy mô lớn sẽ tốt hơn. Theo dữ liệu nội bộ, bộ đôi này có thể truyền dữ liệu nhanh hơn 15 lần so với ghép nối CPU + GPU Hopper truyền thống.

Liên quan đến chủ đề các giải pháp sẵn sàng triển khai, danh mục thiết kế máy chủ Grace CPU Superchip và Grace Hopper Superchip sẽ có các cấu hình một, hai và bốn chiều trên 4 thiết kế dành riêng cho khối lượng công việc, chẳng hạn như:

- Hệ thống NVIDIA HGX Grace Hopper chạy Grace Hopper Superchip + NVIDIA Bluefield-3 DPU

- Hệ thống Grace NVIDIA HGX chạy Grace CPU Superchip + Bluefield-3 DPU

- Hệ thống NVIDIA OVX chạy Grace CPU Superchip + Bluefield-3 DPU + GPU NVIDIA

- Hệ thống NVIDIA CGX chạy Grace CPU Superchip + Bluefield-3 DPU + GPU NVIDIA A16

Một bộ hỗ trợ phần mềm nội bộ đầy đủ bao gồm Omniverse, RTX, NVIDIA HPC và NVIDIA AI sẽ được tối ưu hóa. Các dịch vụ của bên thứ 3 sẽ có nhiều cơ hội nhận được Chứng nhận Hệ thống của NVIDIA nhờ vào việc mở rộng chương trình.

Điện toán GPU quy mô lớn và bảo vệ môi trường với NVIDIA A100 làm mát bằng chất lỏng

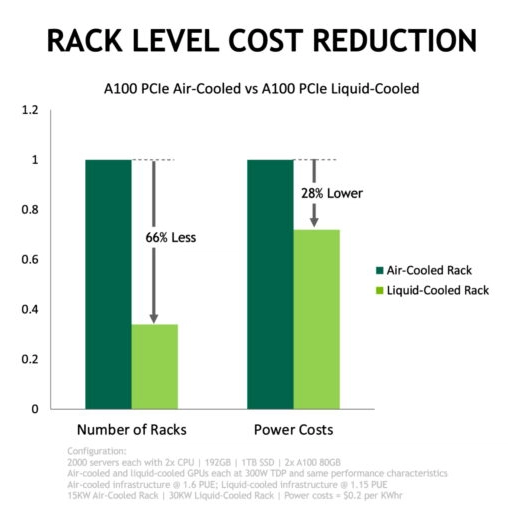

Nhu cầu về điện toán xanh hướng tới các tổ chức quy mô toàn cầu đang có xu hướng tăng lên hàng năm. Các trung tâm dữ liệu lưu trữ và xử lý dữ liệu thực tế là xương sống của Internet hiện đại nhưng việc vận hành các cơ sở hạ tầng ngoại vi này không phải là nhiệm vụ dễ dàng.

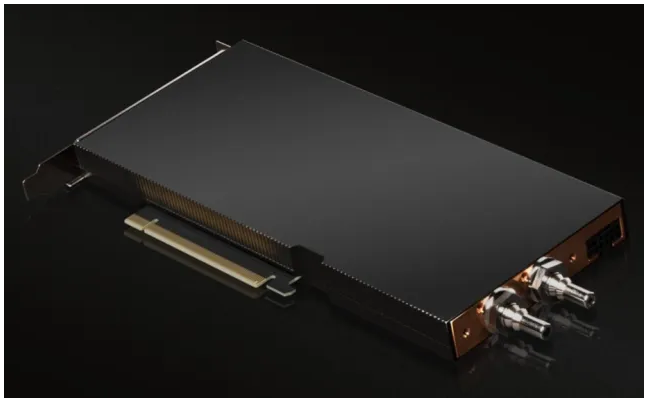

NVIDIA đang thực hiện một bước trong việc cung cấp cho các máy chủ chính thống lựa chọn sử dụng GPU A100 PCIe làm mát bằng chất lỏng với công ty áp dụng đầu tiên là Equinix, một nhà cung cấp dịch vụ toàn cầu có trụ sở tại Hoa Kỳ, đã ra mắt một cơ sở chuyên dụng để theo đuổi những tiến bộ về hiệu quả năng lượng

Ngay cả khi so sánh thiết lập làm mát bằng không khí thông thường, một chuyển đổi đơn giản từ máy chủ chỉ sử dụng CPU sang hệ thống tăng tốc GPU trong trường hợp AI và HPC trên toàn thế giới có thể tiết kiệm năng lượng khổng lồ 11 nghìn tỷ watt mỗi năm. Tương đương điện năng của khoảng 1.5 triệu hộ gia đình tiêu thụ điện trong 1 năm.

Có thể dễ dàng nhận thấy ưu điểm của GPU A100 PCIe làm mát bằng chất lỏng khi tính toán mức tiêu thụ năng lượng thấp hơn 30%. Bản chất của phương pháp làm mát cho phép GPU chỉ chiếm 1 khe PCIe trong khi làm mát bằng không khí tiêu chuẩn mô hình sử dụng 2 khe gắn. Vì vậy, về cơ bản bạn có thể đóng gói gấp đôi sức mạnh tính toán vào cùng một không gian.

Hiện tại, Equinix đang đủ điều kiện và hoàn thiện GPU làm mát bằng chất lỏng A100 80GB PCIe này để triển khai trong khi tính khả dụng chung dự kiến bắt đầu từ Mùa hè này.

Máy chủ và thiết bị Jetson AGX Orin hoàn toàn mới của đối tác NVIDIA

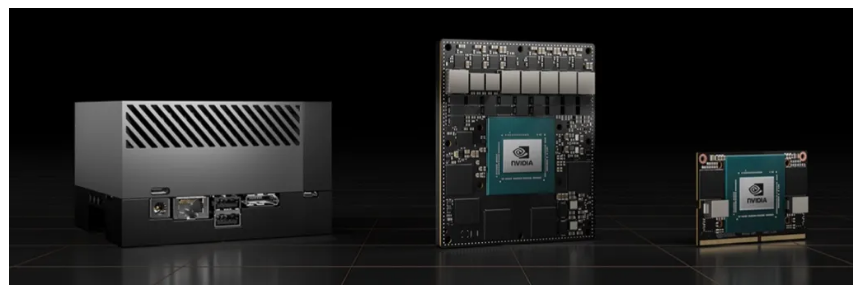

Ngoài các dự án nội bộ của chính NVIDIA, hơn 30 đối tác của NVIDIA sẽ sử dụng hệ thống sản xuất Jetson AGX Orin mới để đưa những gì Team Green đang làm lên một tầm cao mới.

Trong trường hợp bạn không quen thuộc với chủ đề này, NVIDIA Jetson về cơ bản là gói Hệ thống trên mô-đun (SoM) kết hợp mọi thứ mà ứng dụng AI cần bao gồm GPU, bộ nhớ, kết nối, quản lý nguồn, giao diện, v.v. , thành một hệ số dạng duy nhất và dễ truy cập.

Là những dịch vụ mới nhất, bộ công cụ dành cho nhà phát triển Jetson AGX Orin, đã đến tay các nhà phát triển vào tháng 3 năm nay. Có kiến 1 triệu nhà phát triển và hơn 6,000 công ty đã xây dựng các sản phẩm thương mại cho nền tảng Jetson.

Là GPU dựa trên kiến thúc Ampere, CPU Arm Cortex-A78AE, bộ tăng tốc thị giác và học sâu thế hệ tiếp theo được kết nối bằng giao diện tốc độ cao và băng thông bộ nhớ nhanh hơn đồng thời được tăng cường bởi hỗ trợ cảm biến đa phương thức có khả năng cung cấp nhiều đường ống ứng dụng AI đồng thời, Jetson AGX Orin tự tin là ông hoàng của thị trường AI tiên tiến.

Về khung thời gian phát hành, NVIDIA đã cho biết thời gian cho các mô-đun sản xuất Jetson AGX Orin là tháng 7 trong khi các mô-đun Orin NX là vào tháng 9.

Về hình thức tham gia thị trường, các sản phẩm dựa trên Jetson linh hoạt hơn bạn nghĩ vì chúng có thể là máy chủ, thiết bị biên, PC công nghiệp, bo mạch chủ, phần mềm AI, v.v. Quạt làm mát là tùy chọn tùy thuộc vào sự hiện diện của các hạn chế về nhiệt và có rất nhiều thương hiệu sẵn sàng tung ra chúng trong những ngày tới và đó là những loại sau:

Tóm lại, nền tảng Jetson cũng cho phép các nhà phát triển giải quyết một số vấn đề khó khăn nhất bằng cách cung cấp hỗ trợ phần mềm toàn diện có khả năng xử lý một số mô hình phức tạp nhất trong hiểu biết ngôn ngữ tự nhiên, nhận thức 3D, kết hợp đa cảm biến và các lĩnh vực khác.